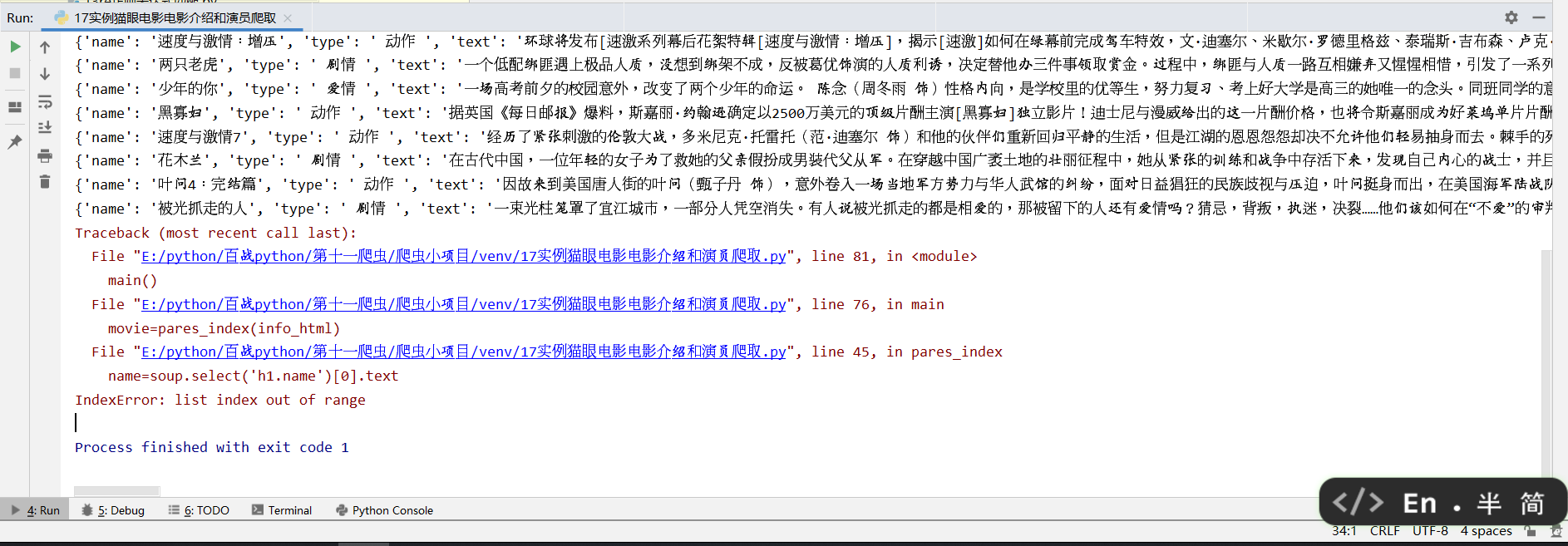

爬取与分析的代码都没有问题,但是总是偶尔出现这样的不能完全爬取的问题,网页的代码与写的分析一致就是不知道原因,有时候能爬取,有时候就会这样子报错

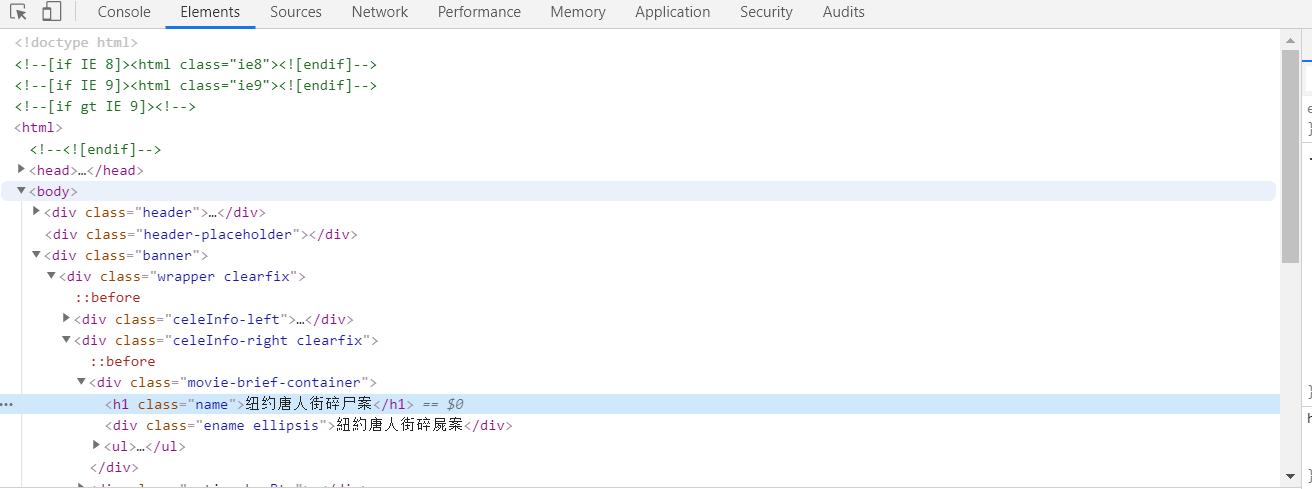

这是下一个的网页代码

老师你帮我看下问题在哪里,https://maoyan.com/films?showType=3这是网址

分享:利用Scrapy框架爬取数据命令行保存成csv出现乱码的解决办法

https://blog.csdn.net/zhaomengszu/article/details/88658108

在创建项目的settings.py中,添加如下代码

FEED_EXPORT_ENCODING = 'gb18030'

即可解决乱码问题。

但是这样做的一个副作用是:在用pycharm打开时可能出现乱码,这时根据提示reload in GBK即可