import requests

# import execjs

from Crypto.Cipher import AES

def get_data():

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/125.0.0.0 Safari/537.36',

}

params = {

'pg': '27',

'pgsz': '15',

'total': '450',

}

# 获取数据

response = requests.get(

'https://jzsc.mohurd.gov.cn/APi/webApi/dataservice/query/project/list',

params=params,

headers=headers,

)

return response.text

def decrypt(data,key,iv):

# 创建一个AES解密的对象

cipher = AES.new(key,AES.MODE_CBC,iv)

# 将数据转成对象所支持的类型bytes

tmp_data = bytes.fromhex(data)

# 解析数据

rs = cipher.decrypt(tmp_data)

return rs

if __name__ == '__main__':

# 初始化iv,key

iv = b'0123456789ABCDEF'

key = b'Dt8j9wGw%6HbxfFn'

# 要解密的数据

t = get_data()

print(t)

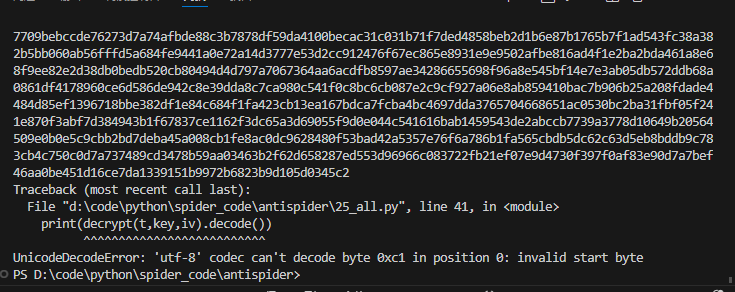

print(decrypt(t,key,iv).decode())

老师,我这个报错怎么解决啊,decode()不行